L’Arte Contemporanea a Castello di Ama

8 Dicembre 2025

Europa ridotta a mercato: il nuovo disegno delle potenze globali

9 Dicembre 2025

di Alfredo Herbin

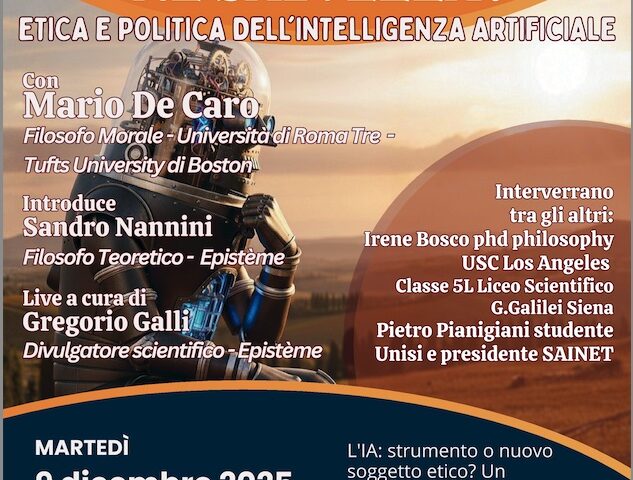

Martedì 9 dicembre al Santa Chiara Lab si discuterà di etica e politica dell’intelligenza artificiale con Mario De Caro, ordinario di Filosofia morale a Roma Tre. Il titolo della conferenza – “Né apocalisse né salvezza?” – suona programmatico: promette un approccio equilibrato, lontano dagli estremi. Ma è proprio qui che sorge il sospetto. Perché in tempi in cui la via media rischia di essere solo l’assenza di posizione, occorre chiedersi: equilibrio rispetto a cosa? Moderazione in nome di quali interessi?

De Caro, ci viene detto, indagherà la possibilità che l’IA diventi “soggetto etico”, che comprenda il linguaggio, sviluppi creatività e coscienza. Ma questa formulazione stessa tradisce un’ingenuità filosofica preoccupante. Parlare dell’IA come possibile “soggetto etico” significa già aver naturalizzato un’attribuzione di soggettività che dovrebbe invece essere radicalmente messa in questione. Non si tratta di verificare se l’IA può diventare cosciente, ma di interrogare perché insistiamo nel proiettare su algoritmi deterministici categorie che appartengono all’essere-nel-mondo umano. È questa proiezione – non l’IA in sé – il vero problema filosofico e politico.

Il comunicato promette anche un’analisi dei “rischi e opportunità” connessi alla trasformazione del nostro agire, dall’esercizio dei diritti al futuro della democrazia. Ma qui manca completamente la domanda decisiva: chi governa questi sistemi? Chi accumula potere e profitto attraverso l’IA? Quali strutture di dominio vengono rafforzate sotto la retorica neutrale dell’innovazione tecnologica?

Parlare di etica dell’IA senza nominare la concentrazione oligopolistica di questi strumenti nelle mani di pochissime corporation, senza affrontare il loro impiego sistematico in dispositivi di sorveglianza e controllo, senza interrogare la distruzione di lavoro e conoscenza che stanno producendo, significa fare filosofia morale come esercizio accademico, non come pensiero che si misura con il reale.

Il rischio è che questa conferenza sia l’ennesima occasione in cui si discute dell’IA nei termini che il sistema tecnologico stesso impone: come se fosse un neutro oggetto di studio, come se le questioni etiche fossero separabili dalle strutture economiche e politiche che determinano lo sviluppo e l’uso di queste tecnologie. Come se bastasse un “approccio equilibrato” per esorcizzare contraddizioni che sono costitutive del modo in cui il capitalismo contemporaneo sta ridefinendo produzione, soggettività e forme di vita.

Heidegger ci ha insegnato che la tecnica moderna non è un mezzo neutrale ma un modo di disvelare il mondo, una “Gestell” che pre-determina il nostro rapporto con l’ente riducendolo a fondo disponibile. L’intelligenza artificiale radicalizza questa imposizione: non è uno strumento che possiamo usare bene o male, ma un dispositivo che già sta riconfigurando le condizioni stesse del pensare e dell’agire. Discuterne in termini di “né apocalisse né salvezza” può sembrare saggio, ma rischia di essere solo la formula retorica con cui ci assolviamo dall’urgenza di un pensiero radicale.

Sarebbe più onesto ammettere che di fronte all’IA non abbiamo ancora le categorie adeguate per pensarla, che la filosofia morale tradizionale rischia di essere impotente, che servirebbero strumenti concettuali nuovi – e forse anche forme di resistenza politica che la conferenza di martedì probabilmente non nominerà.

L’incontro si terrà alle 17:00 nell’Auditorium Santa Chiara Lab, con introduzione di Sandro Nannini. Sarà trasmesso in streaming. Andrà ascoltato, certo. Ma con orecchio critico, senza cedere alla tentazione del pensiero conciliante che lascia intatto lo stato delle cose.

La conferenza “Né apocalisse né salvezza?” fa parte del ciclo “Idee in Movimento”, nato dalla collaborazione tra Università di Siena e Circolo culturale Epistème. Info: terzamissione.unisi.it